Introduzione

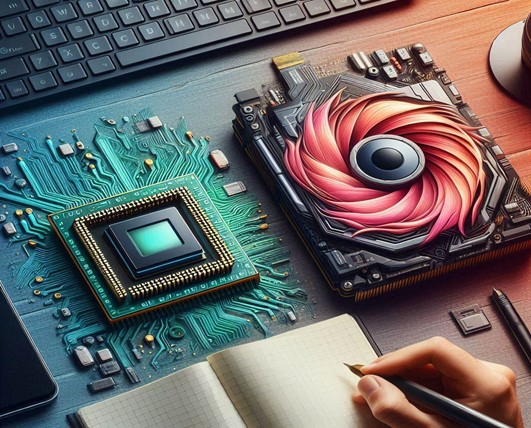

Negli ultimi anni, l’AI ha visto una crescita esponenziale, spinta in gran parte da progressi nel campo dell’hardware. In particolare, le unità di elaborazione grafica (GPU) hanno rivoluzionato il settore, offrendo prestazioni senza precedenti per il training e l’inferenza dei modelli di machine learning. Tuttavia, nel panorama dell’IA, non sono solo le GPU a giocare un ruolo cruciale. CPU, TPU e NPU sono altre componenti hardware fondamentali che meritano attenzione.

Questo articolo esplora le caratteristiche distintive di ciascun tipo di hardware e fornisce indicazioni su quale GPU utilizzare per l’IA.

CPU vs TPU vs NPU vs GPU

CPU (Central Processing Unit)

Le CPU sono i processori tradizionali, utilizzati per eseguire le istruzioni di programmi e sistemi operativi. Sebbene possano gestire operazioni di deep learning su scala ridotta, non sono ideali per il training di modelli di intelligenza artificiale di grandi dimensioni a causa delle loro limitate capacità di elaborazione parallela.

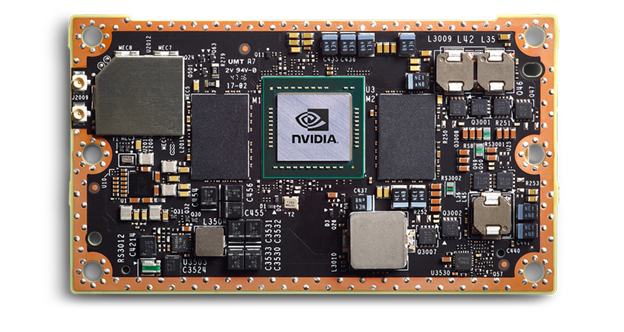

GPU (Graphics Processing Unit)

Originariamente progettate per l’elaborazione di immagini e video, le GPU si sono evolute in potenti processori versatili, capaci di gestire una vasta gamma di compiti di calcolo parallelo. Grazie alla loro architettura, che permette di eseguire molte operazioni simultaneamente, le GPU sono particolarmente adatte per applicazioni di machine learning, mining di criptovalute, montaggio video e elaborazione di immagini.

TPU (Tensor Processing Unit)

Sviluppate da Google, le TPU sono circuiti integrati specifici per applicazioni (ASIC) progettati per accelerare i carichi di lavoro di machine learning. Le TPU sono ottimizzate per compiti essenziali delle reti neurali, come le moltiplicazioni di matrici, offrendo prestazioni ed efficienza energetica superiori rispetto alle GPU in alcuni contesti.

NPU (Neural Processing Unit)

Le NPU sono acceleratori hardware specializzati progettati per eseguire compiti di reti neurali con alta efficienza. Questi processori sono particolarmente adatti per dispositivi mobili, edge computing e altre applicazioni sensibili al consumo energetico. Le NPU offrono un’alternativa valida alle GPU, soprattutto per l’esecuzione di inferenze su dispositivi embedded.

Quale GPU Utilizzare per l'AI?

Nella scelta di una GPU per l’intelligenza artificiale, NVIDIA è senza dubbio il leader di mercato. La linea di GPU NVIDIA offre una vasta gamma di opzioni, da modelli consumer-grade a soluzioni professionali per il calcolo ad alte prestazioni.

NVIDIA A100

Questa GPU di alto livello, basata sull’architettura Ampere, è progettata per il machine learning, l’IA e altre applicazioni di calcolo intensivo. Con una memoria HBM2 e capacità di diverse decine di gigabyte, l’A100 è ideale per il training di modelli di deep learning di grande scala.

NVIDIA Grace Hopper Superchip

Combinando CPU e GPU, questo superchip offre una piattaforma potente per il calcolo ad alte prestazioni. Il DGX GH200, un supercomputer di large memory, combina fino a 256 superchip Grace Hopper, offrendo una capacità di memoria condivisa di 144 terabyte e una performance AI di quattro petaflop (numero di operazioni in virgola mobile eseguite in un secondo da un processore).

Le GPU più recenti di NVIDIA includono Tensor Cores (acceleratori NVIDIA specializzati per l’AI che potenziano l’addestramento e l’inferenza dei modelli) altamente ottimizzati per i modelli AI, sono in grado di adattarsi automaticamente alla precisione ottimale necessaria per processare transformer models, la classe di reti neurali che ha dato origine alla Generative AI.

L'Importanza del Software

Oltre all’hardware, il software svolge un ruolo cruciale nel massimizzare le capacità delle GPU. La piattaforma NVIDIA AI include centinaia di librerie e applicazioni software che supportano ogni aspetto dell’IA, dai componenti di deep-tech alle applicazioni di alto livello. Il linguaggio di programmazione CUDA e la libreria cuDNN-X per il deep learning forniscono una base solida su cui gli sviluppatori possono costruire i loro modelli.

NVIDIA X ChatGPT

Un esempio eclatante dell’efficacia delle GPU NVIDIA è il modello linguistico di grandi dimensioni (LLM) alla base di ChatGPT, che è stato addestrato e funziona su migliaia di GPU NVIDIA. Questo modello di IA generativa è utilizzato da oltre 100 milioni di persone, dimostrando la capacità delle GPU di gestire carichi di lavoro di AI su larga scala.

Conclusione

Le GPU continuano a essere la scelta dominante per il machine learning e l’intelligenza artificiale, grazie alla loro capacità di elaborazione parallela e alla vasta gamma di software di supporto.

Tuttavia, CPU, TPU e NPU offrono soluzioni complementari e, in alcuni casi, superiori per specifici carichi di lavoro di IA. La scelta del giusto hardware dipende dalle esigenze specifiche del progetto, dal tipo di modelli di AI utilizzati e dal contesto applicativo.

Mentre NVIDIA continua a dominare il mercato delle GPU, le TPU di Google e le NPU emergenti stanno ampliando le opzioni disponibili per i ricercatori e gli sviluppatori di AI.

A cura di Raffaele Disabato

*scopri le nostre soluzioni R.A.G., Gen AI e Private AI rivolte alle aziende!!